國防醫學系教授兼副系主任

三總教學部師資培育科主任

王志嘉

人工智慧於醫療、教學與研究的倫理與法律議題初探

人工智慧(Artificial Intelligence, 以下簡稱 AI)係指由人類開發機器所展現的智慧行為,其範圍包括演繹推理、問題解決、規劃與學習、自然語言處理、感知系統乃至創造力等。近年來,AI快速融入醫療領域,應用層面從疾病診斷、影像判讀、輔助醫療決策,到病人照護等,對於臨床實務造成的影響與日俱增,此外,在生成式AI興起後,AI在醫學教育與研究的導入日益頻繁,AI對於醫療、教學與研究所帶來的倫理與法律衝擊亦逐漸浮現,成為當今醫學教育思潮必須具備的專業素養。

人工智慧的倫理與法律議題

- 綜覽人工智慧衍生的倫理議題

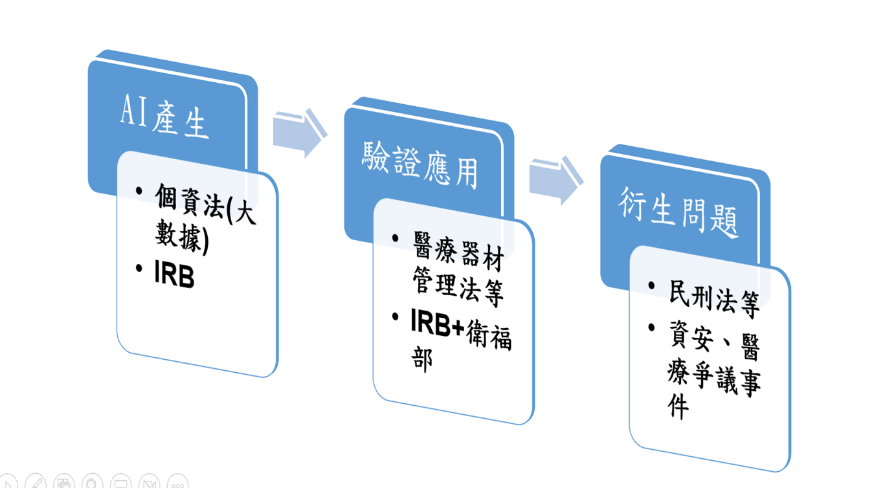

從醫療實務的觀察,人工智慧的發展過程,大致可分為三個階段(圖一):

- 人工智慧的產生:本質上就是由大數據(big data)與深度學習(deep learning)/機器學習(machine learning)所構成,這部分主要涉及大數據使用以及深度學習的倫理與法律議題,在醫療實務上,通常需要經過IRB的審核通過。

- 人工智慧的驗證:人工智慧產生後,在醫療場域上,本質上屬於醫用軟體,未來如欲應用於病人身上,須考慮是否屬於醫療器材軟體,通常需經機構 IRB 審核通過及衛福部核准。

- 人工智慧的應用:經過驗證的人工智慧可以應用於病人,在使用上可能涉及資訊隱私、準確度、以及後續衍生的醫療爭議的民刑事責任。

圖一:人工智慧的倫理與法律議題示意圖(作者自製)

- 人工智慧產出的倫理與法律議題

AI的產生所涉及的倫理與法律議題,主要可由大數據與深度學習分析。

對於【醫療大數據】部分,個人資料保護法、最高行政法院106年度判字第54號判決以及憲法法庭憲判字第13號判決,已有清楚的輪廓。

從個人資料保護法第1條、第6條、第15條及第16條等規定,以健保資料庫為例,醫療大數據的使用至少須符合執行法定職務、特定目的、公共利益、無從識別當事人以及資訊安全維護機制等面向綜合檢視。

最高行政法院106年度判字第54號判決認為醫療大數據合法化的依據,除推定有公共利益外,主要的重點在於:必須將病人的個資去識別化、必須有資訊安全維護機制,以及病人無退出健保資料庫的權利,此判決肯認前述個人資料保護法的規定。

111年8月12日憲法法庭憲判字第13號判決,肯認健保個資經去識別化提供研合憲,但有三部分違憲,包括:欠缺個人資料保護的獨立監督機制、資料庫的使用涉及人民資訊隱私權,應有明確的法律授權、以及允許病人有退出的請求權,且應於3年內修正完成,故預計本(114)年8月12日前對於醫療數據如何符合倫理與法律的使用規範將更為明確與依循。

AI的演算具有不可解釋性 (lack of explainability),亦即俗稱的黑盒子 (black-box nature),以及不可駕馭性(limited controllability)。

- 人工智慧驗證的倫理議題

人工智慧於醫療領域的應用,如醫學影像處理軟體、AI 聽診器的開發,其本質屬於「醫用軟體」,如需量產並應用於病人身上,就會變成「醫療器材軟體」,要如何經過驗證,是否如同新醫療器材須進行嚴謹的四期臨床試驗,有待法規進一步釐清,惟儘管法規仍有不確定性,至少須經IRB與衛福部審核通過,並取得受試者同意書,是目前的共識。

- 人工智慧應用的倫理議題

人工智慧應用於醫療實務或教學研究時,常見的倫理與法律爭議,包括:

- 涉及資訊隱私權、自主權與資料保護,例如未經使用者同意,將健康數據提供予第三方共享,或將病人資料於原有目的之外再用於新的演算法訓練或研究。

- 偏見與不透明性,AI 模型的訓練依賴大量歷史資料,若該資料本身存有偏見,(如種族、性別、年齡差異),AI 就會延續或放大這些偏見,例如若該資料以白人族群為主,則所訓練出的 AI 若用於其他有色人種族群,診斷結果即可能產生偏差,如過去著名的亞馬遜徵才案,其AI系統自動對女性應徵者進行扣分,進而引發性別歧視與偏見之爭議。。

- 產生數位不平等,AI或數位科技並非人人享有,若未考量弱勢族群,如偏鄉地區因缺乏穩定網路與設備,可能使健康照護更為失衡,或是部分高齡者、低教育程度者或語言障礙族群,對於 AI 系統操作或理解其運作方式可能感到困難,也可能衍生數位不平等的爭議,這是在AI發展過程需要注意的地方。

- 適用當責性(Accountability)與醫療爭議責任:使用醫療用的AI,如發生醫師與AI判斷不一致或是AI誤診其責任之歸屬,或是特斯拉自駕車禍案等,無論是醫療(含教育或研究)或生活上的使用,AI 僅為輔助角色,使用者仍應承擔當責性,即具備最終決策責任,至於相關醫療爭議責任的判斷,複雜性甚高,將不於本文討論。

二、初探生成式人工智慧於醫學教育與研究之應用

自ChatGPT於2022年11月公開問世,首次推出GPT-3.5的架構,立即引起全球的關注,隨後在2023年推出功能更強的GPT-4至今,持續對於醫療實務、教育與研究產生巨大的影響,由於發展迅速,諸多議題仍方興未艾,相關倫理與法律討論尚待建構,故本節僅以「初探」方式,探討生成式 AI 在醫學教學與研究中所呈現的倫理與法律議題,並聚焦在學生與教師(含研究者),以及審查者使用生成式AI等部分討論。

- 學生或教師(研究者)使用生成式AI的倫理

- 使用生成式AI繳交作業或產生計畫

學生或研究者,若透過生成式AI直接撰寫作業、報告或是研究計畫時,除內容未必準確外,亦可能衍生抄襲與學術誠信的問題,進而違反自主、誠信與正義等基本倫理原則。

因為,學術的創作,主要來自於個人的思考,若作業或研究中直接使用生成式AI產生內容而未揭露,除侵犯教師或審查者的自主權(知情權),作者也等同放棄思考與分析責任,削弱了知識生產中的個人自主性,同時也讓教師或審查者無法得知學生或研究者的真實表現,進而有違反學術倫理所強調的誠信原則之虞。

- 以生成式AI輔助作業或研究計畫繳交

如前所述,生成式 AI 所產生的內容無法直接作為個人原創,如以生成式AI輔助作業或研究計畫的繳交,通常可用於言語潤飾或摘要整理,更重要的是其內容必須經過使用者的修改始符合倫理,並應於必要時揭露使用 AI 輔助的內容與方式。

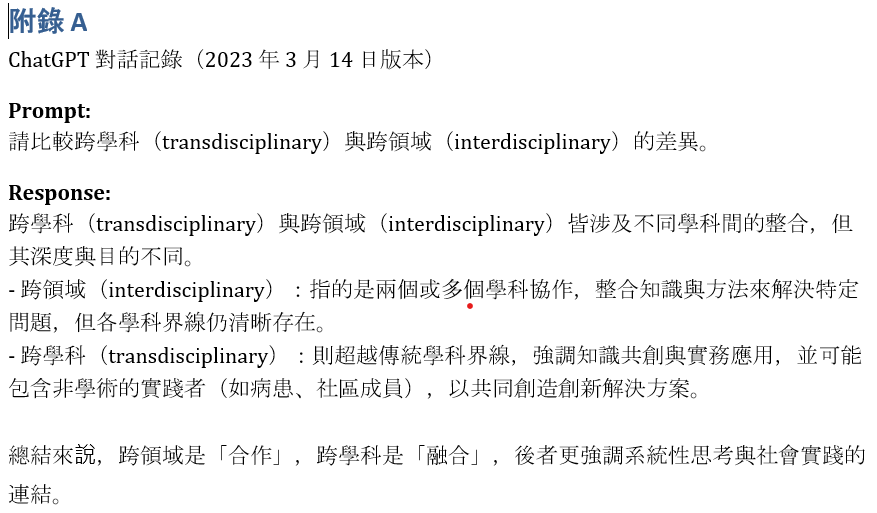

近年來,投稿時有不少文章會要求揭露是否有使用生成式AI。如申請研究計畫於文獻回顧有使用生成式AI探討「transdisciplinary與interdisciplinary」的差異,可以揭露:「本研究撰寫過程中,使用生成式AI工具(如ChatGPT)進行初步文獻分類與摘要整理,最終內容經作者人工審核與引用確認。」有些文章會要求以附錄說明(Appendix on AI Use)使用生成式AI生成的內容,以增加其透明度與信任度(圖二)。

因此,教師、研究者與審查者應共同建立生成式 AI 使用的專業素養,確保教育與研究過程中的倫理信任基礎。

圖二:比較transdisciplinary與interdisciplinary的差異(由GPT4產生)

- 使用生成式AI繳交作業或產生計畫

- 審查者使用生成式AI的倫理

近年來不論是論文審查或研究計畫對審查者的審查須知,常會提到不能使用生成式AI進行審查,主要的倫理考量,審查者未實際審閱內容,而直接請生成式 AI 撰寫審查建議,不僅違反學術倫理中的誠信原則,亦可能導致審查責任無法釐清,一般在論文投稿未刊登前,接觸到的人員(雜誌社或是審查者)負有保密義務,若將論文內容輸入生成式AI進行分析,不僅可能違反保密義務,亦可能造成資料外洩風險。

因此,目前對於論文或研究計畫的審查者,對於使用生成式AI進行審查,通常有以下的倫理與法考慮,包括:

- 審查者應保密評審內容,不應將尚未公開的論文或研究計畫的內容輸入開放的生成式AI平台(如ChatGPT),以避免資料外洩。

- 不應讓生成式AI取代專業審查意見形成,如直接請AI列出審查建議,未經本人審閱或校正即提交審查意見。

- 生成式AI可以用來輔助理解技術內容或搜尋背景文獻,但不建議直接複製AI生成意見作為審查回饋。

- 使用生成式AI可以協助語言潤飾或重述審查意見,且保留審查者本人的專業判斷與最終責任。

三、結論

數位醫療專家Bertalan Meskó博士於2018年AMEE大會演講提到:「人工智慧不會取代醫師,但不懂得使用人工智慧的醫師,將被懂得使用人工智慧的醫師所取代。(Artificial intelligence is not going to replace physicians. But those who do not know and utilize artificial intelligence will absolutely be replaced by those who know and utilize artificial intelligence.)」這句話顯示醫療專業人員在數位轉型時代中,必須具備人工智慧素養的重要性,尤其在醫學教育與研究領域,人工智慧的應用日益廣泛,從課程設計、臨床模擬到研究分析,皆可能涉及到AI技術,此外,資訊隱私、演算法偏差與歧視、決策透明度及當責性等相關倫理與法律議題亦日益受到重視,是現代醫學教育思潮下不可或缺的專業素養。

參考文獻

- Floridi, L., Cowls, J., King, T. C., & Taddeo, M. (2020). How to design AI for social good: Seven essential factors. Science and Engineering Ethics, 26(3), 1771–1796.

- Mesko, B. (2018). Science fiction in medical education. Plenary presentation at the AMEE 2018 Conference, Basel, Switzerland.

- Meskó, B., Hetényi, G., & Győrffy, Z. (2018). Will artificial intelligence solve the human resource crisis in healthcare?. BMC health services research, 18(1), 545. https://doi.org/10.1186/s12913-018-3359-4

- Obermeyer, Z., Powers, B., Vogeli, C., & Mullainathan, S. (2019). Dissecting racial bias in an algorithm used to manage the health of populations. Science, 366(6464), 447–453. https://doi.org/10.1126/science.aax2342

- 臺灣大學數位學習中心(2023)。臺大針對生成式 AI 工具之教學因應措施。檢索日期:2025年5月4日,取自 https://www.dlc.ntu.edu.tw/ai-tools/

- 王志嘉#、陳煥武(2023)。智慧醫療與醫材之應用與相關法律責任。台灣醫療法律雜誌,4(1),63–89。